agent aws bash centos certificado cidade viva cluster conteiner devops dica docker elastic elasticsearch git gitops grafana helm jenkins k8s kibana kubernetes linux livro logstash master mysql nexus novatec prometheus puppet puppet-br puppetboard puppetdb puppetserver redhat saltstack script server shell swarm terraform tutoriais tutorial zabbix zabbix-br

Livros: Jenkins, Puppet, Zabbix e ICD.

Sobre

Aécio Pires

Curso remoto de Kubernetes e Docker

Blog

Instalando o Zabbix no Kubernetes usando o Helm

Introdução Confesso que demorei muito para publicar este post, porque o médodo de instalação do Zabbix no Kubernetes usando o Helm não é algo novo. Isso já é feito em alguns ambientes há alguns anos. Eu mesmo ajudo no desenvolvimento de um helm chart há quase 3 anos. Mas aqui estamos… De 2013 para cá, Leia mais sobreInstalando o Zabbix no Kubernetes usando o Helm[…]

Deploy de aplicações no Kubernetes usando Argo CD com suporte a Helm, Sops e Multiple Sources

Em outro tutorial, eu falei sobre a abordagem GitOps e uso do Argo CD para deploy de aplicações em clusters Kubernetes… Recomendo a leitura para entender alguns conceitos antes de partir para o assunto que será explicado aqui. Multiple Sources Quando eu escrevi o tutorial anterior, o Argo CD estava na versão 2.1.1 e não tinha suporte a deploy Leia mais sobreDeploy de aplicações no Kubernetes usando Argo CD com suporte a Helm, Sops e Multiple Sources[…]

Usando o Flux CD para implementar a abordagem GitOps nos clusters Kubernetes

Em outro tutorial, eu falei sobre a abordagem GitOps e uso do ArgoCD… Recomendo a leitura para entender alguns conceitos antes de partir para o uso da ferramenta que será explicado aqui. Neste tutorial você aprenderá a instalar o Flux, que é conjunto de soluções de entrega contínua e progressiva para Kubernetes. Fonte: https://fluxcd.io. O Leia mais sobreUsando o Flux CD para implementar a abordagem GitOps nos clusters Kubernetes[…]

Usando o Argo CD para implementar a abordagem GitOps nos clusters Kubernetes

Atualizado em: 28/03/2024 Sobre o GitOps GitOps é uma estrutura operacional que utiliza as melhores práticas da cultura DevOps durante o ciclo de vida das aplicações, tais como: controle de versão, colaboração, conformidade e ferramentas de integração, entrega e deploy contínuo (CI/CD), e as aplica à automação da infraestrutura. Fonte: Gitlab. Imagine o seguinte cenário: Leia mais sobreUsando o Argo CD para implementar a abordagem GitOps nos clusters Kubernetes[…]

Instalando o k0s (distribuição Kubernetes all-inclusive)

Atualizado em: 04 de fevereiro de 2024 k0s é uma distribuição do Kubernetes com todos os recursos necessários para funcionar em um único e pequeno binário desenvolvido em Go, que proporciona uma simplicidade na instalação e manutenção do cluster. A pronúncia é correta é kay-zero-ess e tem por objetivo reduzir o esforço técnico e desgaste Leia mais sobreInstalando o k0s (distribuição Kubernetes all-inclusive)[…]

Instalando o Go

Atualizado em: 17 de fevereiro de 2024 Se você ainda não sabe o que é Go, recomendo ver os links que estão neste tutorial. Para instalar o Go no Linux, execute os seguintes comandos: VERSION=1.22.0 cd /tmp mkdir -p $HOME/go/bin curl https://dl.google.com/go/go$VERSION.linux-amd64.tar.gz -o go.tar.gz sudo rm -rf /usr/local/go sudo tar -C /usr/local -xzf go.tar.gz rm Leia mais sobreInstalando o Go[…]

Primeiros passos com Go

Olá! Estou começando a dar os primeiros passos com o Go e quero compartilhar os links que já estudei até aqui e que servem de bússola para quem quer começar a usá-lo também. Esta página será atualizada à medida que eu encontrar mais documentos relevantes. http://aprendago.com – Curso gratuito de Go em pt-BR com Ellen Leia mais sobrePrimeiros passos com Go[…]

Tutorial de criação de um cluster Kubernetes com Terraform e AWS-EKS

Atualizado em: 14 de junho de 2021 Oi, pessoal! No blog da Sensedia tinha sido publicado um tutorial que André Déo e eu escrevemos sobre como criar um cluster Kubernetes na AWS-EKS utilizando Terraform. O link original é este aqui: https://br.sensedia.com/post/how-create-cluster-kubernetes-terraform-aws-eks. Inicialmente o post fala sobre a instalação do EKS na versão 1.17, mas o Leia mais sobreTutorial de criação de um cluster Kubernetes com Terraform e AWS-EKS[…]

Criando JSON mais simples em Shell Script com JO e JJ

Não sei vocês, mas acho muito chato criar JSON em shell script com o comando jq. Eu trabalhei em algo semelhante esses dias, então investi algumas horas pesquisando e achei o comando jo (https://github.com/jpmens/jo) Tem disponível para ser instalado no Ubuntu, ArchLinux e outras distros GNU/Linux. Exemplo de uso: jo -p name=jo n=17 parser=false Resultado: Leia mais sobreCriando JSON mais simples em Shell Script com JO e JJ[…]

Codeac: Suporte e novidades

Oi, pessoal! Ano passado eu tinha compartilhado minhas primeiras impressões ao utilizar o Codeac (esse nome é inspirado em um urso que vive no Alasca e se chama Kodiak. Então Codeac é um trocadilho ou brincadeira com a pronúncia ao incluir a palavra code (código em inglês). Veja o post anterior aqui. Há poucos dias Leia mais sobreCodeac: Suporte e novidades[…]

Instalando o R-Studio via Docker

R é uma linguagem de programação de código fonte aberto especializada em computação estatística e gráficos. Há uma grande quantidade de documentação sobre o uso do R nos links a seguir: https://www.r-project.org/doc/bib/R-books.html https://cran.r-project.org/manuals.html https://education.rstudio.com/learn/beginner/ https://learning.oreilly.com/search/?query=R https://www.packtpub.com/catalogsearch/result/?q=R https://www.youtube.com/watch?v=lVKMsaWju8w O R-Studio é uma IDE (Integrated Development Environment) que facilita o desenvolvimento de código utilizando o R. O Leia mais sobreInstalando o R-Studio via Docker[…]

InfluxDB 1.x, Prometheus 2.x e Grafana 6.x

InfluxDB InfluxDB é um banco de dados para armazenamento de séries temporais. Ele possui o código fonte aberto e disponível em: https://github.com/influxdata/influxdb O InfluxDB inclui APIs para armazenar e consultar dados, processando-os em segundo plano para fins de monitoramento, geração de alertas, exibição de dashboards, exploração dos dados e muito mais. Ele também possui outros Leia mais sobreInfluxDB 1.x, Prometheus 2.x e Grafana 6.x[…]

InfluxDB 2.0 e Telegraf 2.0 e Prometheus 2.x

Atenção: Até o momento em que este tutorial foi elaborado (14 de maio de 2020) o InfluxDB 2.0 está na versão beta e ainda não é recomendado para ser utilizado em produção e o Prometheus 2.x ainda não é completamente compatível com a API do InfluxDB 2.0. Para uso em produção é recomendado o InfluxDB Leia mais sobreInfluxDB 2.0 e Telegraf 2.0 e Prometheus 2.x[…]

AWS-EKS – Cluster Kubernetes 1.20 provisionado com Terraform

Atualizado em: 14 de junho de 2021 Nos últimos dias venho testando o Kubernetes 1.20 no AWS-EKS com as versões mais novas dos módulos e providers Terraform + Terragrunt para AWS-EKS. O código Terraform + Terragrunt usado para subir o cluster EKS no ambiente de teste está disponível em: https://github.com/aeciopires/adsoft/tree/master/eks/ Inclusive nesse repositório tem muito Leia mais sobreAWS-EKS – Cluster Kubernetes 1.20 provisionado com Terraform[…]

Codeac: ferramenta para analisar a qualidade do código que gerencia a infraestrutura e aplicação

Após uma postagem no Twitter de Rafael Gomes (Gomex) e Amaury Souza no Slack infraascode citando o Codeac.io, resolvi dedicar um tempo estudar e testar a ferramenta. Codeac faz a análise da qualidade, olhando não apenas o código da aplicação, mas também do código que gerencia a infraestrutura a ser usada pela aplicação (Exemplo: Dockerfile, Leia mais sobreCodeac: ferramenta para analisar a qualidade do código que gerencia a infraestrutura e aplicação[…]

Primeiros passos com o Prometheus

Olá! Estou começando a dar os primeiros passos com o Prometheus e quero compartilhar os links que já estudei até aqui e que servem de bússola para quem quer começar a usá-lo também. Esta página será atualizada à medida que eu encontrar mais documentos relevantes. Tutoriais: https://medium.com/tech-grupozap/prometheus-monitorando-a-sa%C3%BAde-da-sua-aplica%C3%A7%C3%A3o-bd9b3b63e7b1 https://medium.com/schkn/monitoring-linux-processes-using-prometheus-and-grafana-113b3e271971 https://labs.bawi.io/monitorando-containers-com-prometheus-379affd87113 https://dzone.com/articles/monitoring-with-prometheus https://devconnected.com/category/monitoring/prometheus/ https://www.booleanworld.com/install-use-prometheus-monitoring/ https://tech.willhaben.at/monitoring-metrics-using-prometheus-a6d498dfcfba https://linoxide.com/containers/setup-monitoring-docker-containers-prometheus/ https://docs.docker.com/config/thirdparty/prometheus/ Leia mais sobrePrimeiros passos com o Prometheus[…]

Instalando o Prometheus via Docker

Atualizado em: 25 de julho de 2022 O Prometheus é um kit de ferramentas de monitoramento e alerta de sistemas de código aberto inspirado no BorgMon (o sistema de monitoramento do Borg, plataforma de gerenciamento de conteiners do Google que inspirou o desenvolvimento do Kubernetes). Foi criado originalmente por ex-funcionários do Google que trabalharam na Leia mais sobreInstalando o Prometheus via Docker[…]

Primeiros passos com o Elasticsearch

Olá! Estou começando a dar os primeiros passos com o Elasticsearch e quero compartilhar os links que já estudei até aqui e que servem de bússola para quem quer começar a usá-lo também. Esta página será atualizada à medida que eu encontrar mais documentos relevantes. API cluster: https://www.elastic.co/guide/en/elasticsearch/reference/current/cluster.html https://www.elastic.co/guide/en/elasticsearch/reference/6.5/getting-started-explore.html https://sysadmins.co.za/how-to-setup-a-2-node-elasticsearch-cluster-on-centos-7-with-some-example-usage/ https://fdv.github.io/running-elasticsearch-fun-profit/006-operating-daily/006-operating-daily.html Apostila e livro sobre Leia mais sobrePrimeiros passos com o Elasticsearch[…]

Instalando o RabbitMQ via Docker

Atualizado em: 25 de julho de 2022 O RabbitMQ é serviço de gerenciamento de filas para recebimento e entrega de mensagens entre aplicações, mesmo que tenham sido desenvolvidas em diferentes linguagens de programação. Ele é gratuito e possui o código fonte aberto e disponível em: https://github.com/rabbitmq. Utiliza o protocolo AMQP para realizar a troca de Leia mais sobreInstalando o RabbitMQ via Docker[…]

Primeiros passos com RabbitMQ

Olá! Estou começando a dar os primeiros passos com o RabbitMQ e quero compartilhar os links que já estudei até aqui e que servem de bússola para quem quer começar a usá-lo também. Esta página será atualizada à medida que eu encontrar mais documentos relevantes. RabbitMQ para iniciantes: https://helloflu.wordpress.com/2015/12/17/rabbitmq-for-beginners/ https://www.tutlane.com/tutorial/rabbitmq https://www.concrete.com.br/2012/01/26/rabbitmq-conceitos-basicos/ https://www.rabbitmq.com/getstarted.html https://www.rabbitmq.com/tutorials/tutorial-one-python.html Gerenciando o Leia mais sobrePrimeiros passos com RabbitMQ[…]

Livro: Integração Contínua Com Jenkins

Nesta manhã foi publicado um novo livro pela editora Novatec, escrito por mim e Janaína Militão, sobre o uso do Jenkins integrado a ferramentas que apoiam a cultura DevOps, tais como: Gogs, Docker, Sonarqube, Terraform, Nexus. O objetivo do livro é ensinar como integrar essas ferramentas para construir um processo automatizado de integração, entrega e Leia mais sobreLivro: Integração Contínua Com Jenkins[…]

Primeiros passos com Ansible

Olá! Estou começando a dar os primeiros passos com o Ansible e quero compartilhar os links que já estudei até aqui e que servem de bússola para quem quer começar a usá-lo também. Esta página será atualizada à medida que eu encontrar mais documentos relevantes. Vídeos: https://www.youtube.com/watch?v=BYM6tqn2UvQ&t https://www.youtube.com/watch?v=eTDhKoP4Uns Documentação: https://pt.slideshare.net/RodrigoLira16/instalando-e-mantendo-o-zabbix-com-ansible http://blog.rivendel.com.br/2018/02/05/ansible-dicas-para-quem-esta-comecando-a-usar-a-ferramenta-de-automacao/ http://ansible-br.org https://www.ansible.com https://docs.ansible.com https://www.ansible.com/overview/how-ansible-works Leia mais sobrePrimeiros passos com Ansible[…]

Primeiros passos com SaltStack

Olá! O SaltStack é uma ferramenta de código fonte aberto que realiza a gerência de configuração de servidores, serviços, conteineres e equipamentos de rede. Ela é uma alternativa a ferramentas como: Ansible (https://www.ansible.com), Puppet (https://puppet.com) e Chef (https://www.chef.io/chef). Update: O SaltStack foi adquirido pela VmWare em Outubro/2020, mas parte do projeto continuará opensource no site Leia mais sobrePrimeiros passos com SaltStack[…]

Puppet 6: Instalando o PuppetDB e integrando ao PuppetServer e PuppetBoard no Ubuntu Server 18.04, Debian 9, CentOS/Red Hat 7

Aviso: Este tutorial foi escrito para ensinar a montar um servidor Puppet usando os pacotes Puppet-Server e PuppetDB (da PuppetLabs) e PuppetBoard. Este ambiente usa pacotes do Puppet 6.x. Se você ainda não sabe o que é Puppet, como funciona e para que serve, sugiro parar por aqui e começar a estudar pelo livro que Leia mais sobrePuppet 6: Instalando o PuppetDB e integrando ao PuppetServer e PuppetBoard no Ubuntu Server 18.04, Debian 9, CentOS/Red Hat 7[…]

Puppet 6: Instalando o Configurando o Puppet-Server e Puppet-Agent no CentOS/Red Hat 7.x

Aviso: Este tutorial ensina a montar o ambiente usando o Puppet 6.x. Se você ainda não sabe o que é Puppet, como funciona e para que serve, sugiro parar por aqui e começar a estudar pelo livro que publiquei pela Novatec https://novatec.com.br/livros/puppet/, pelos links que estão nesta página: http://blog.aeciopires.com/primeiros-passos-com-o-puppet/. Quando estiver se sentindo seguro no assunto, Leia mais sobrePuppet 6: Instalando o Configurando o Puppet-Server e Puppet-Agent no CentOS/Red Hat 7.x[…]

Puppet 6: Instalando o Configurando o Puppet-Server e Puppet-Agent no Debian 9 e Ubuntu Server 18.04

Aviso: Este tutorial ensina a montar o ambiente usando o Puppet 6.x. Se você ainda não sabe o que é Puppet, como funciona e para que serve, sugiro parar por aqui e começar a estudar pelo livro que publiquei pela Novatec https://novatec.com.br/livros/puppet/, pelos links que estão nesta página: http://blog.aeciopires.com/primeiros-passos-com-o-puppet/ Quando estiver se sentindo seguro no assunto, Leia mais sobrePuppet 6: Instalando o Configurando o Puppet-Server e Puppet-Agent no Debian 9 e Ubuntu Server 18.04[…]

Conhecendo o Gogs

Atualizado em: 14 de junho de 2021 O Gogs é um software de código fonte aberto que oferece uma interface web ao gerenciamento de repositórios git similar ao GitHub, GitLab e Bitbucket, só que muito mais simples e leve que os três anteriores. O impressionante é que um conteiner Docker do Gogs estava funcionando consumindo Leia mais sobreConhecendo o Gogs[…]

Primeiros passos com Python

Depois de 10 anos sem fazer um “Helllo World” em Python, estou reaprendendo esta linguagem (a última vez tinha sido entre 2008 e 2009 quando fazia parte do Núcleo Comunicação Digital no IFPB). Neste post quero compartilhar os links de estudo que estou lendo ou pretendo ler. Assim espero contribuir de alguma forma com que Leia mais sobrePrimeiros passos com Python[…]

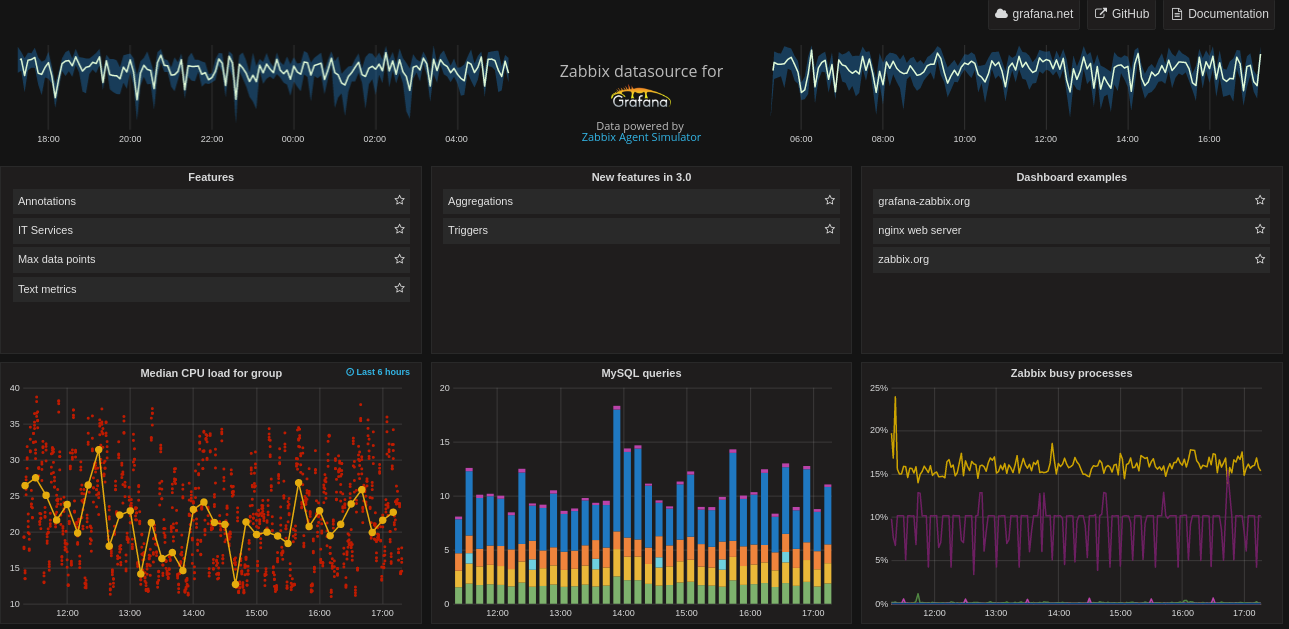

Integrando o Grafana ao ELK (ElasticSearch, Logstash e Kibana)

Essa dica é indicada para quem procura uma interface web alternativa ao Kibana que seja elegante e simples de usar. Como eu já conheço e uso o Grafana integrado ao Zabbix para visualizar os dados coletados em gráficos e dashboards mais elegantes, pesquisei um pouco e vi que o Grafana já tem uma integração completa Leia mais sobreIntegrando o Grafana ao ELK (ElasticSearch, Logstash e Kibana)[…]

Conhecendo o JHipster Console

Atualizado em: 25 de julho de 2022 O JHipster Console é um sistema baseado no ELK Stack, que foi mostrado como instalá-lo via Docker neste post. Ele é mais uma das ferramentas de apoio do framework JHipster (que facilita a criação de microsserviços em Java). O JHipster Console fornece uma configuração padrão para iniciar o Leia mais sobreConhecendo o JHipster Console[…]

Conhecendo o Terraform

Atualizado em: 25 de julho de 2022 O Terraform é uma ferramenta para construir, alterar e configurar uma infraestrutura de rede de forma segura e eficiente. Com ele é possível gerenciar serviços de nuvem bem conhecidos, bem como soluções internas personalizadas. Veja a lista completa de serviços de infraestrutura de nuvem suportados em: https://www.terraform.io/docs/providers/index.html. Os arquivos Leia mais sobreConhecendo o Terraform[…]

Conheça o Puppet Bolt

Neste post no blog da Instruct foi apresentado uma descrição sobre os objetivos do Puppet Bolt, um novo produto da empresa Puppet que vem para ajudar o trabalho do administrador de sistemas e de rede. O Puppet Bolt serve para executar comandos, tarefas, scripts em vários hosts simultaneamente. E o melhor: não precisa instalar nada Leia mais sobreConheça o Puppet Bolt[…]

Instalando o Elastic, Kibana e LogStash via Docker

Atualizado em: 17 de fevereiro de 2024 Nesta página do Elastic (também conhecido com ElasticSearch) tem várias informações a cerca da instalação do stack ELK (Elastic, LogStash e Kibana). A instalação usando o Docker é bem mais simples e rápida. Se você não sabe o que é Docker, recomendo começar lendo os links abaixo. É um Leia mais sobreInstalando o Elastic, Kibana e LogStash via Docker[…]

Parabéns Zabbix-BR!

Hoje a comunidade Zabbix-BR está em festa! http://zabbixbrasil.org/?p=2300 Parabéns a todos que contribuem para esse crescimento.

Instalando o Grafana via Docker

Atualizado em: 25 de julho de 2022 Observando as páginas abaixo sobre a documentação da instalação do Grafana via Docker, foi elaborado o seguinte tutorial para instalá-lo. http://docs.grafana.org/installation/docker/ http://docs.grafana.org/installation/configuration/ Se você não sabe o que é Docker, recomendo começar lendo os links desta página. É um longo caminho, mas vale a pena conhecer essa tecnologia. Leia mais sobreInstalando o Grafana via Docker[…]

Boxes do Vagrant

O Vagrant é um software que permite criar máquinas virtuais (para Virtualbox ou Vmware) de forma simples para agilizar a criação de ambientes de testes e desenvolvimento. Mais informações podem ser obtidas no site https://www.vagrantup.com Para automatizar e simplificar a criação de máquinas virtuais com Vagrant, você pode criar um arquivo chamado Vagranfile e nele Leia mais sobreBoxes do Vagrant[…]

Módulo puppet_sslforfree 1.0.0

Olá, pessoal! Acabou de sair do forno, um módulo que ajuda a distruibuir e atualizar os certificados gerados pelo site https://www.sslforfree.com/. Através desse site você pode ter acesso a um certificado válido para um host ou um domínio inteiro gratuitamente. Esse site usa a API do let’s encrypt. Mas como o certificado só tem validade Leia mais sobreMódulo puppet_sslforfree 1.0.0[…]

Primeiros passos com Jenkins

Olá! Estou começando a dar os primeiros passos com o Jenkins e quero compartilhar os links que já estudei até aqui e que servem de bússola para quem quer começar a usá-lo também. Esta página será atualizada à medida que eu encontrar mais documentos relevantes. Blogs: https://jenkins.io/doc/book/getting-started/ https://jenkins.io/user-handbook.pdf https://www.tutorialspoint.com/jenkins/index.htm https://www.tutorialspoint.com/jenkins/jenkins_tutorial.pdf http://www.devopsschool.com/tutorial/jenkins/ https://www.tutorialspoint.com/jenkins/index.htm Temas: http://afonsof.com/jenkins-material-theme/ Livros: Leia mais sobrePrimeiros passos com Jenkins[…]

Puppet 5: Instalando o PuppetDB e integrando ao PuppetServer e PuppetBoard no Ubuntu Server 16.04/18.04, Debian 9, CentOS 7 e Red Hat 7

Aviso: Este tutorial foi escrito para ensinar a montar um servidor Puppet usando os pacotes Puppet-Server e PuppetDB (da PuppetLabs), PuppetExplorer (da Spotify) e PuppetBoard. Este ambiente usa pacotes do Puppet 5.x. Se você ainda não sabe o que é Puppet, como funciona e para que serve, sugiro parar por aqui e começar a estudar Leia mais sobrePuppet 5: Instalando o PuppetDB e integrando ao PuppetServer e PuppetBoard no Ubuntu Server 16.04/18.04, Debian 9, CentOS 7 e Red Hat 7[…]

Puppet 5: Instalando o Configurando o Puppet-Server e Puppet-Agent no CentOS/Red Hat 7.x

Aviso: Este tutorial ensina a montar o ambiente usando o Puppet 5.x. Se você ainda não sabe o que é Puppet, como funciona e para que serve, sugiro parar por aqui e começar a estudar pelo livro que publiquei pela Novatec https://novatec.com.br/livros/puppet/, pelos links que estão nesta página: http://blog.aeciopires.com/primeiros-passos-com-o-puppet/. Quando estiver se sentindo seguro no assunto, Leia mais sobrePuppet 5: Instalando o Configurando o Puppet-Server e Puppet-Agent no CentOS/Red Hat 7.x[…]

Puppet 5: Instalando o Configurando o Puppet-Server e Puppet-Agent no Debian 9 e Ubuntu Server 16.04/18.04

Aviso: Este tutorial ensina a montar o ambiente usando o Puppet 5.x. Se você ainda não sabe o que é Puppet, como funciona e para que serve, sugiro parar por aqui e começar a estudar pelo livro que publiquei pela Novatec https://novatec.com.br/livros/puppet/, pelos links que estão nesta página: http://blog.aeciopires.com/primeiros-passos-com-o-puppet/ Quando estiver se sentindo seguro no assunto, Leia mais sobrePuppet 5: Instalando o Configurando o Puppet-Server e Puppet-Agent no Debian 9 e Ubuntu Server 16.04/18.04[…]

Lançamento do livro: Gerência de configuração com Puppet

Quero divulgar com vocês o novo livro recém lançado pela editora Novatec. O livro impresso custa R$ 45, mas se usarem o código de desconto PUPPET, até o dia 09/11, conseguem comprar por R$ 33,75 + frete. https://novatec.com.br/livros/puppet/ O livro também está disponível em e-book nos links abaixo pelo preço de R$ 36. E-book no Leia mais sobreLançamento do livro: Gerência de configuração com Puppet[…]

Instalando o Graylog via Docker

Atualizado em: 17 de fevereiro de 2024 Nesta página do Graylog tem várias informações a cerca da instalação do Graylog usando imagens Docker para Graylog, MongoDB e ElasticSearch. Segundo este tutorial, o Graylog é executado usando um conteiner Docker, o que deixa a instalação bem simples e rapidamente você tem o serviço funcionando. Se você não sabe o que Leia mais sobreInstalando o Graylog via Docker[…]

Instalando o WordPress via Docker

Atualizado em: 25 de julho de 2022 Nesta página do Docker Store tem várias informações a cerca das imagens oficiais do WordPress no Docker. Segundo este tutorial, o WordPress é executado usando um conteiner Docker, o que deixa a instalação bem simples e rapidamente você tem o serviço funcionando. Se você não sabe o que Leia mais sobreInstalando o WordPress via Docker[…]

Instalando o GitLab via Docker

Atualizado em: 25 de julho de 2022 Na página https://docs.gitlab.com/ee/install/docker.html tem várias informações a cerca das imagens Docker oficiais do GitLab (ferramenta web para versionamento usando o Git). Neste tutorial, o Gitlab será executado usando um único conteiner para fornecer todo o ambiente necessário para executá-lo, o que deixa a instalação bem simples e rapidamente Leia mais sobreInstalando o GitLab via Docker[…]

Instalando o Docker, Docker Swarm, Docker Registry e Portainer

Atualizado em: 25 de julho de 2022 Instalando o Docker O Docker pode ser instalado no Ubuntu seguindo o seguinte tutorial: https://docs.docker.com/engine/installation/linux/docker-ce/ubuntu/ Para instalá-lo em outras distribuições GNU/Linux acesse o link abaixo. https://docs.docker.com/engine/installation/ Iniciando o Swarm (Cluster Docker) O swarm já é instalado junto com o Docker. Inicie o swarm com o comando abaixo. sudo Leia mais sobreInstalando o Docker, Docker Swarm, Docker Registry e Portainer[…]

Instalando o Zabbix via Docker

Atualizado em: 06 de abril de 2023 Neste repositório do GitHub tem várias informações sobre o uso das imagens oficiais do Zabbix no Docker. As instruções oficiais para instalação do Zabbix com Docker estão disponíveis em: https://www.zabbix.com/documentation/current/en/manual/installation/containers Se você não sabe o que é Docker, recomendo começar lendo os links abaixo. Vale a pena conhecer essa Leia mais sobreInstalando o Zabbix via Docker[…]

Instalando o Redmine via Docker

Atualizado em: 22 de julho de 2022. Neste repositório do GitHub tem um tutorial para executar o Redmine no Docker. Segundo o tutorial, o Redmine é executado usando um conteiner Docker, o que deixa a instalação bem simples e rapidamente você tem o serviço funcionando. Se você não sabe o que é Docker, recomendo começar lendo Leia mais sobreInstalando o Redmine via Docker[…]

Instalando o Sonatype Nexus via Docker

Atualizado em: 25 de julho de 2022 Neste repositório do GitHub tem um tutorial para executar o Sonatype Nexus (repositório de artefatos gerados pelo Apache Maven). Segundo o tutorial, o Nexus é executado usando um conteiner Docker, o que deixa a configuração bem simples e rapidamente você tem o serviço funcionando. Se você não sabe Leia mais sobreInstalando o Sonatype Nexus via Docker[…]

Modelo de Script com uso de getopts para passagem de parametros

Para fazer scripts profissionais e voltados a usuários iniciantes, temos que tomar uma série de cuidados, como por exemplo, exibir um help sobre o funcionamento do script, permitir passagem de parâmetros, checar se os parâmetros informados são válidos, se solicitarmos o uso de arquivos, verificar se o usuário possui o privilégio mínimo requerido naquele Leia mais sobreModelo de Script com uso de getopts para passagem de parametros[…]

Lançamento da versão 2.4.x da Apostila sobre Puppet

Olá! Há poucos minutos foi lançada a versão 2.4.0 da apostila sobre Puppet, mantida pela comunidade Puppet-BR. Vocês podem baixar o PDF final aqui: http://apostila.puppet-br.org Quem quiser ajudar na edição e atualização da apostila, pode ter acesso ao código fonte e as instruções aqui: https://github.com/puppet-br/apostila-puppet Bons estudos! Abraço e fica com Deus. 🙂

Instalando o PuppetDB e integrando ao PuppetServer e ao PuppetExplorer e PuppetBoard no Ubuntu Server 14.04/16.04, Debian 8, Red Hat 6 e 7 e CentOS 6 e 7

Aviso: Este tutorial foi escrito para ensinar a montar um servidor Puppet usando os pacotes Puppet-Server e PuppetDB (da PuppetLabs), PuppetExplorer (da Spotify) e PuppetBoard. Este ambiente usa pacotes do Puppet 4.x. Se você ainda não sabe o que é Puppet, como funciona e para que serve, sugiro parar por aqui e começar a estudar Leia mais sobreInstalando o PuppetDB e integrando ao PuppetServer e ao PuppetExplorer e PuppetBoard no Ubuntu Server 14.04/16.04, Debian 8, Red Hat 6 e 7 e CentOS 6 e 7[…]

Novidades sobre o curso “De A a Zabbix”

Olá! Eu, André Déo e Adail Spinola, somos autores do livro “De A a Zabbix“. Se você ainda não leu o livro ou deseja aprender mais sobre Zabbix (http://zabbix.com) pode participar de um curso presencial com um de nós. Os cursos são presenciais realizados em datas e cidades diferentes, de acordo com a diponibilidade de Leia mais sobreNovidades sobre o curso “De A a Zabbix”[…]

Primeiros passos com Docker, Kubernetes, Helm e Istio

Olá! Estou começando a dar os primeiros passos com o Docker, Kubernetes, Helm e Istio. Quero compartilhar os links que já estudei até aqui e que servem de bússola para quem quer começar a aprender também. Esta página será atualizada à medida que eu encontrar mais documentos relevantes. Links sobre Docker: Curso Docker https://www.docker.com/what-docker https://porter.io/github.com/veggiemonk/awesome-docker Leia mais sobrePrimeiros passos com Docker, Kubernetes, Helm e Istio[…]

Configurando o Grafana para funcionar sobre HTTPS

Neste tutorial http://zabbixbrasil.org/?p=1674, eu e André Déo mostramos como instalar o Grafana no Debian 8, CentOS 7 e Ubuntu 16.04 (ambos 64 bits). Nesse mesmo tutorial é mostrada a integração do Grafana com o Zabbix. Agora será mostrado como configurar o Grafana para funcionar sobre HTTPS, usando um certificado auto-assinado. Criando um certificado auto-assinado Instale o Leia mais sobreConfigurando o Grafana para funcionar sobre HTTPS[…]

Customizando o Glassfish 4 no Ubuntu 16.04

Hoje (25/08/2017), a versão do Glassfish Open Source Edition mais recente e recomendada para uso em produção é a 4.1.2, que pode ser obtida nesta página: https://glassfish.java.net/download.html Para usar o Glassfish 4 é necessário instalar o Java 8, que pode ser obtido neste link http://www.oracle.com/technetwork/java/javase/downloads/index.html e instalado no Ubuntu seguindo este tutorial: http://www.webupd8.org/2012/09/install-oracle-java-8-in-ubuntu-via-ppa.html O Glassfish padrão contém algumas Leia mais sobreCustomizando o Glassfish 4 no Ubuntu 16.04[…]

Customizando o Tomcat 8

Informações iniciais Hoje (03/08/2016), a versão do Tomcat mais recente e recomendada para uso em produção é a 8.5.4, que pode ser obtida nesta página: https://tomcat.apache.org/download-80.cgi Para usar o Tomcat 8 é necessário instalar o Java 8. O Java 8 da Oracle pode ser obtido neste link http://www.oracle.com/technetwork/java/javase/downloads/index.html e instalado no Ubuntu seguindo este tutorial: http://www.webupd8.org/2012/09/install-oracle-java-8-in-ubuntu-via-ppa.html O Tomcat padrão contém Leia mais sobreCustomizando o Tomcat 8[…]

Cluster Ativo/Passivo com PostgreSQL 9.3, Red Hat 6, pcs, Pacemaker, Corosync e DRBD

Introdução Para a execução deste tutorial foram criadas duas máquinas virtuais com as configurações abaixo. Processador: 1 vCPU com clock acima de 2.0 GHz. Memória: 1 GB. HD1: 50 GB (com duas partições: / de 42 GB e swap de 8 GB). HD2: 20 GB (mas este não foi configurado durante a instalação do S.O). Leia mais sobreCluster Ativo/Passivo com PostgreSQL 9.3, Red Hat 6, pcs, Pacemaker, Corosync e DRBD[…]

Configurando Link Failover no Mikrotik

Olá! Estou compartilhando um documento elaborado por Victor Igor, que trabalha comigo na Dynavideo. Este documento ensina como configurar o mikrotik para verificar se um link está funcionando e, em caso de falha, redirecionar o tráfego da rede interna por outro link de redundância ou backup. O documento também explica como implementar regras de NAT Leia mais sobreConfigurando Link Failover no Mikrotik[…]

Configurando um ambiente Puppet-Server e Puppet-Agent no CentOS 6 e 7/Red Hat 6 e 7

Aviso: Este tutorial foi atualizado para ensinar a montar o ambiente puppet usando o repositório da PuppetLabs para instalar pacotes do Puppet 4.x. Se você ainda não sabe o que é Puppet, como funciona e para que serve, sugiro parar por aqui e começar a estudar pelo livro que publiquei pela Novatec https://novatec.com.br/livros/puppet/, pelos links que Leia mais sobreConfigurando um ambiente Puppet-Server e Puppet-Agent no CentOS 6 e 7/Red Hat 6 e 7[…]

Configurando um ambiente Puppet-Server e Puppet-Agent no Debian 8 e Ubuntu Server 14.04/16.04

Aviso: Este tutorial foi atualizado para ensinar a montar o ambiente puppet usando o repositório da PuppetLabs para instalar pacotes do Puppet 4.x. Se você ainda não sabe o que é Puppet, como funciona e para que serve, sugiro parar por aqui e começar a estudar pelo livro que publiquei pela Novatec https://novatec.com.br/livros/puppet/, pelos links que Leia mais sobreConfigurando um ambiente Puppet-Server e Puppet-Agent no Debian 8 e Ubuntu Server 14.04/16.04[…]

Primeiros passos com o Puppet

Olá! Estou começando a dar os primeiros passos com o Puppet e quero compartilhar os links que já estudei até aqui e que servem de bússola para quem quer começar a usá-lo também. Esta página será atualizada à medida que eu encontrar mais documentos relevantes. O que é DevOps? Por que mudar para a cultura Leia mais sobrePrimeiros passos com o Puppet[…]

[DICA AVANÇADA] Exercício com LLD personalizado e log no formato CSV

Oi, pessoal! Compartilho o link abaixo referente a um exercício com LLD personalizado e log no formato CSV, assunto abordado no capítulo 11 do livro De A Zabbix. http://zabbixone.com/?p=364 Bons estudos!

[DICA AVANÇADA] Restringindo o acesso a menus do Zabbix

Atualizado em 19/01/2017. Dica testada apenas no Zabbix 2.4.X. O Zabbix tem três perfis(papeis): user (USER_TYPE_ZABBIX_USER), admin (USER_TYPE_ZABBIX_ADMIN) e super admin (USER_TYPE_SUPER_ADMIN). Os menus do Zabbix são exibidos de acordo com o perfil que um usuário possui. Editando o código fonte da interface web do Zabbix é possível restringir o acesso aos menus Leia mais sobre[DICA AVANÇADA] Restringindo o acesso a menus do Zabbix[…]

[DICA AVANÇADA] Desabilitando o acesso a página de configurações do perfil de um usuário no Zabbix

No Zabbix, o link Configurações ou Configurations serve para acessar a página de configurações de perfil de um usuário, onde é possível mudar a senha, linguagem, tema, enfim. Se você quiser criar um usuário só para fins de demonstração ou visualização sem que ele acesse a página Configurações para alterar estes dados, siga o seguinte Leia mais sobre[DICA AVANÇADA] Desabilitando o acesso a página de configurações do perfil de um usuário no Zabbix[…]

Lançamento do livro “De A a Zabbix” no IFPB Campus João Pessoa

Oi, pessoal! O lançamento será nesta sexta-feira (06/03/2015) às 11h. Quem for de João Pessoa e puder ir, vai ser ótimo ver você lá. Haverá um sorteio do livro no final da palestra. A palestra faz parte do evento preparado o início do semestre 2015.1.

Entrevista com os autores do livro “De A a Zabbix”

Oi, pessoal! Há poucos minutos foi publicada uma entrevista comigo, Adail e André no blog da Novatec. Confiram: http://novatec.com.br/blog/entrevista-com-os-autores-livro-de-zabbix/

O livro já está sendo vendido no site da Novatec!

Bom dia, pessoal! Há poucas horas, o livro começou a ser vendido na Novatec com 25% de desconto até o dia 28/02/2015. Acesse o link abaixo para saber como comprar o livro com o desconto. http://zabbixone.com/?p=151 Boa leitura!

Livro “De A a Zabbix” será publicado pela Novatec

Desde 2011 eu, Adail Spínola e André Déo estávamos escrevendo um livro sobre Zabbix. Graças a Deus, já temos uma previsão de que ele seja publicado no mês que vem. 🙂 Saibam mais sobre o livro aqui: http://zabbixone.com/?p=68 Site da Novatec divulgando o livro no final da página inicial. http://www.novatec.com.br/ O livro tem o Leia mais sobreLivro “De A a Zabbix” será publicado pela Novatec[…]

[DICA AVANÇADA] Aumentando a quantidade dos últimos incidentes a serem exibidos no dashboad

Quero compartilhar mais esta dica com você. Se quiser aumentar a quantidade dos últimos incidentes a serem exibidos no dashboard do Zabbix, altere o arquivo PATH_ZABBIX_WEB/include/defines.inc.php. Onde: PATH_ZABBIX_WEB => é o caminho em que estão os arquivos da interface web. No meu caso é o diretório /var/www/html/zbx. Neste arquivo altere a linha, conforme o exemplo Leia mais sobre[DICA AVANÇADA] Aumentando a quantidade dos últimos incidentes a serem exibidos no dashboad[…]

[DICA AVANÇADA] Aumentando o limite de caracteres exibidos pela macro {ITEM.LASTVALUE}

Bom dia! Quero compartilhar esta dica com você: Quem já usou ou quer usar a macro {ITEM.LASTVALUE} no nome ou na descrição de uma trigger precisa saber que, por padrão, só são exibidos os 20 primeiros caracteres. Isto é um problema quando o retorno de um item do tipo texto é usado na descrição de Leia mais sobre[DICA AVANÇADA] Aumentando o limite de caracteres exibidos pela macro {ITEM.LASTVALUE}[…]

Faça parte da missão Portas Abertas

Em alguns lugares do mundo a perseguição aos cristãos é muito mais forte. A Missão Portas Abertas existe com o objetivo de ajudar os cristãos em suas lutas para seguirem em frente sem perder a fé e ainda poder compartilhar o testemunho de vida com outras pessoas. Acesse o site da Missão, conheça o Leia mais sobreFaça parte da missão Portas Abertas[…]

Cidade Viva – Edificando Relacionamentos Acima da Média – Parte I

Fonte: http://cidadeviva.info/mensagens/?id=436

Cidade Viva – Edificando Relacionamentos Acima da Média – Parte II

Fonte: http://cidadeviva.info/mensagens/?id=438

Artigo: Aplicando configurações de segurança na instalação do Zabbix

Oi, pessoal! Como trabalho de conclusão da especialização em segurança da informação na faculdade iDEZ (http://www.faculdadeidez.com.br), escrevi o artigo abaixo. http://zabbixbrasil.org/files/Artigo_Aecio_Pires-Aplicando_recomendacoes_de_seguranca_na_instalacao_do_Zabbix_VERSAO_10.pdf Nas considerações finais são citados outros tópicos de segurança do Zabbix a serem estudados em outros trabalhos acadêmicos. Este artigo foi fruto de um trabalho em equipe: André Déo na revisão, Leandro Almeida, amigo e professor que corrigiu e deu boas Leia mais sobreArtigo: Aplicando configurações de segurança na instalação do Zabbix[…]

Deus usa menino que liga para uma rádio e a sua lição se espalha pelo mundo

Abaixo está o vídeo traduzido: Abaixo está o vídeo original: Site com mais informações sobre o menino chamado Logan Henderson de Whitman, Nebraska, EUA. http://www.clevelandchurch.net/index.php?p=1_215

Testemunhos sobre a vida na Coreia do Norte

A Portas Abertas teve acesso a relatos de quem viu de perto a realidade da Coreia do Norte. Veja os testemunhos abaixo. http://www.portasabertas.org.br/noticias/2013/04/2456990/ http://www.portasabertas.org.br/noticias/2013/04/2451879/ http://www.portasabertas.org.br/noticias/2013/04/2451879/

Testemunho de uma norte-coreana

Nós brasileiros somos muito abençoados por Deus porque todos os dias podemos pegar a Bíblia e lê-la sem correr risco de morrer ou ser preso por esse ato. Veja o testemunho de vida dessa norte-coreana: http://www.portasabertas.org.br/noticias/testemunhos/2013/04/2413509/.

Aumente a segurança do SSH com o SPA

Vou logo avisando que este é um post longo, mas vale à pena você dedicar alguns minutos para lê-lo e aprender como deixar o acesso ao SSH menos vulnerável a ataques usando o SPA. SPA (Single Packet Autorization) é uma técnica baseada em Port Knocking que ajuda a aumentar a segurança do SSH. Como funciona Leia mais sobreAumente a segurança do SSH com o SPA[…]